Liquid Cooling: ตัวจริงด้านระบายความร้อนสำหรับ Data Center ยุค AI

เมื่อโลกหมุนเข้าสู่ยุคที่ AI และ Cloud Computing ใช้ทรัพยากรประมวลผลกันแบบโหดๆ ภายใน Data Center ความร้อนที่เกิดจากเซิร์ฟเวอร์หนาแน่นไม่ใช่เรื่องเล่นๆ อีกต่อไป ระบบทำความเย็นด้วยอากาศแบบเดิมเริ่มไปต่อไม่ไหวแล้ว

นี่จึงเป็นจุดที่ Liquid Cooling ก้าวขึ้นมาเป็นพระเอก ด้วยความสามารถในการถ่ายเทความร้อนที่ดีกว่าอากาศหลายเท่า ช่วยให้ Data Center ทำงานได้เสถียร ประหยัดพลังงาน และพร้อมรองรับ Workload หนักๆ ของอนาคตอย่างแท้จริง

Liquid Cooling คืออะไรกันแน่?

Liquid Cooling คือเทคโนโลยีการระบายความร้อนที่ใช้ ของเหลว เป็นตัวกลางในการดึงความร้อนออกจากอุปกรณ์ภายใน Data Center แทนการใช้ลมเหมือนระบบ Air Cooling ทั่วไป

ด้วยคุณสมบัติทางฟิสิกส์ ของเหลวมีทั้ง ค่าความจุความร้อน (Specific Heat Capacity) และ ค่าสัมประสิทธิ์การนำความร้อน (Thermal Conductivity) สูงกว่าอากาศอย่างชัดเจน ทำให้สามารถดูดซับและพาความร้อนออกจากฮาร์ดแวร์ต่างๆ เช่น CPU, GPU หรือ RAM ได้เร็วกว่าและมีประสิทธิภาพกว่ามาก

หลักการทำงานโดยย่อคือ

ออกแบบให้น้ำหล่อเย็นหรือของเหลวไหลผ่าน Cold Plate ที่ติดแนบอยู่กับอุปกรณ์โดยตรง

หรือในระดับ Advance กว่านั้น คือเอาอุปกรณ์ทั้งชุด จุ่มลงในของเหลว ที่ออกแบบมาเป็นพิเศษ

ผลลัพธ์คือสามารถควบคุมอุณหภูมิได้อย่างคงที่และแม่นยำ ซึ่งเป็นสิ่งสำคัญมากสำหรับอุปกรณ์ IT ประสิทธิภาพสูงที่ไม่ถูกกับความร้อนแม้แต่นิดเดียว

ทำไม Data Center ยุค AI ถึงขาด Liquid Cooling ไม่ได้

หัวใจสำคัญคือ Liquid Cooling ทำให้ Data Center รับมือกับ High Density Rack ได้อย่างจริงจัง

ปัจจุบันมีตู้แร็คที่ดึงไฟตั้งแต่ 30–100 kW ต่อตู้ ซึ่งเป็นระดับที่ระบบ Air Cooling แบบเดิมแทบไม่มีทางเอาอยู่ หากยังยึดติดกับการระบายความร้อนด้วยอากาศ Data Center จะไม่สามารถติดตั้งเซิร์ฟเวอร์หรือ GPU ระดับโหดๆ ที่ใช้ขับเคลื่อน AI และงานประมวลผลหนักๆ ได้เต็มศักยภาพ

พูดง่ายๆ คือ ถ้าไม่มี Liquid Cooling ก็ไม่มีทางดันศักยภาพของ AI และ HPC ได้สุดทาง

สองสายหลักของ Liquid Cooling

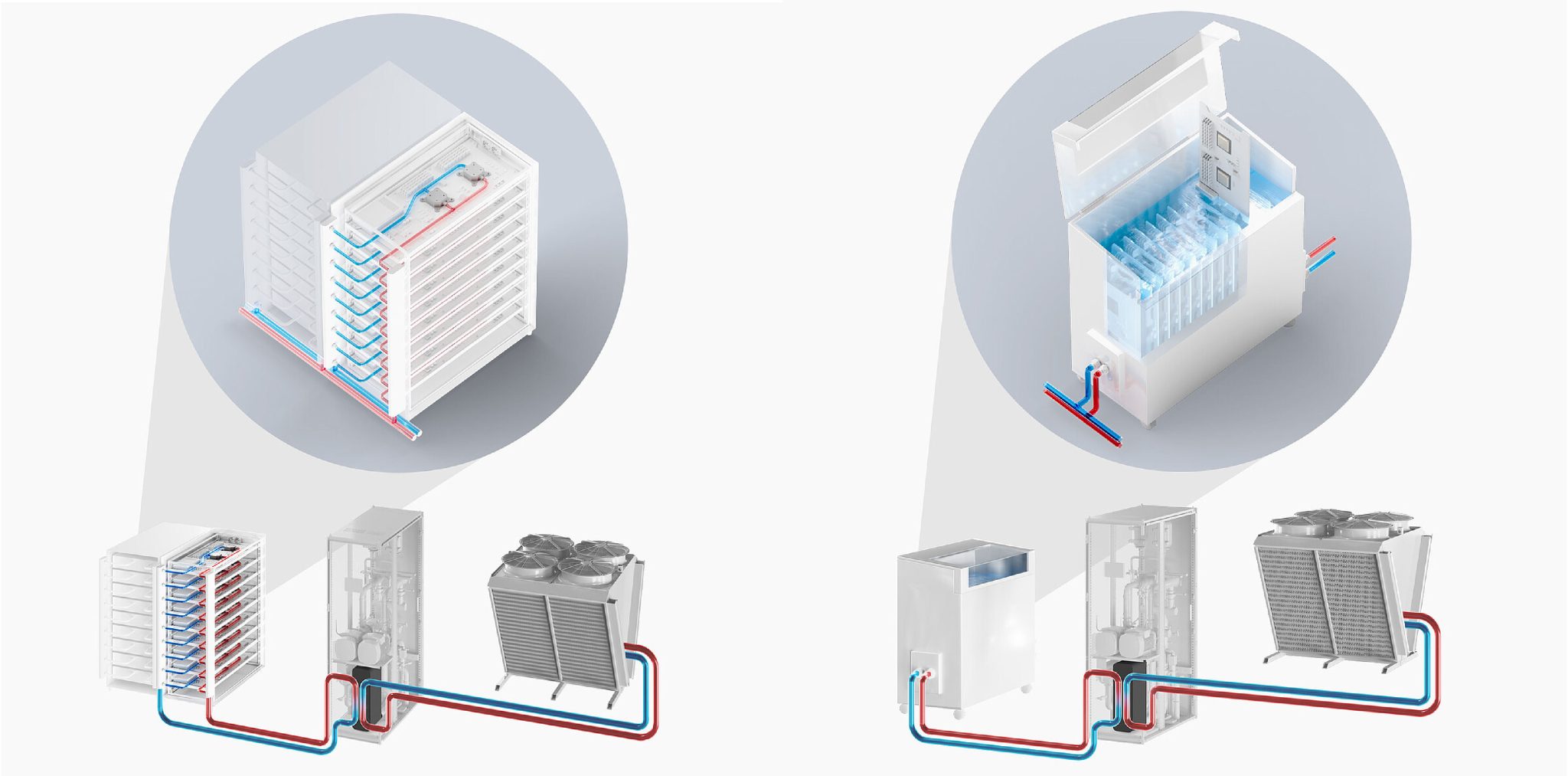

ระบบ Liquid Cooling แบ่งใหญ่ๆ ได้เป็น 2 แนวทาง ขึ้นอยู่กับวิธีที่ของเหลวเข้าไปสัมผัสกับอุปกรณ์

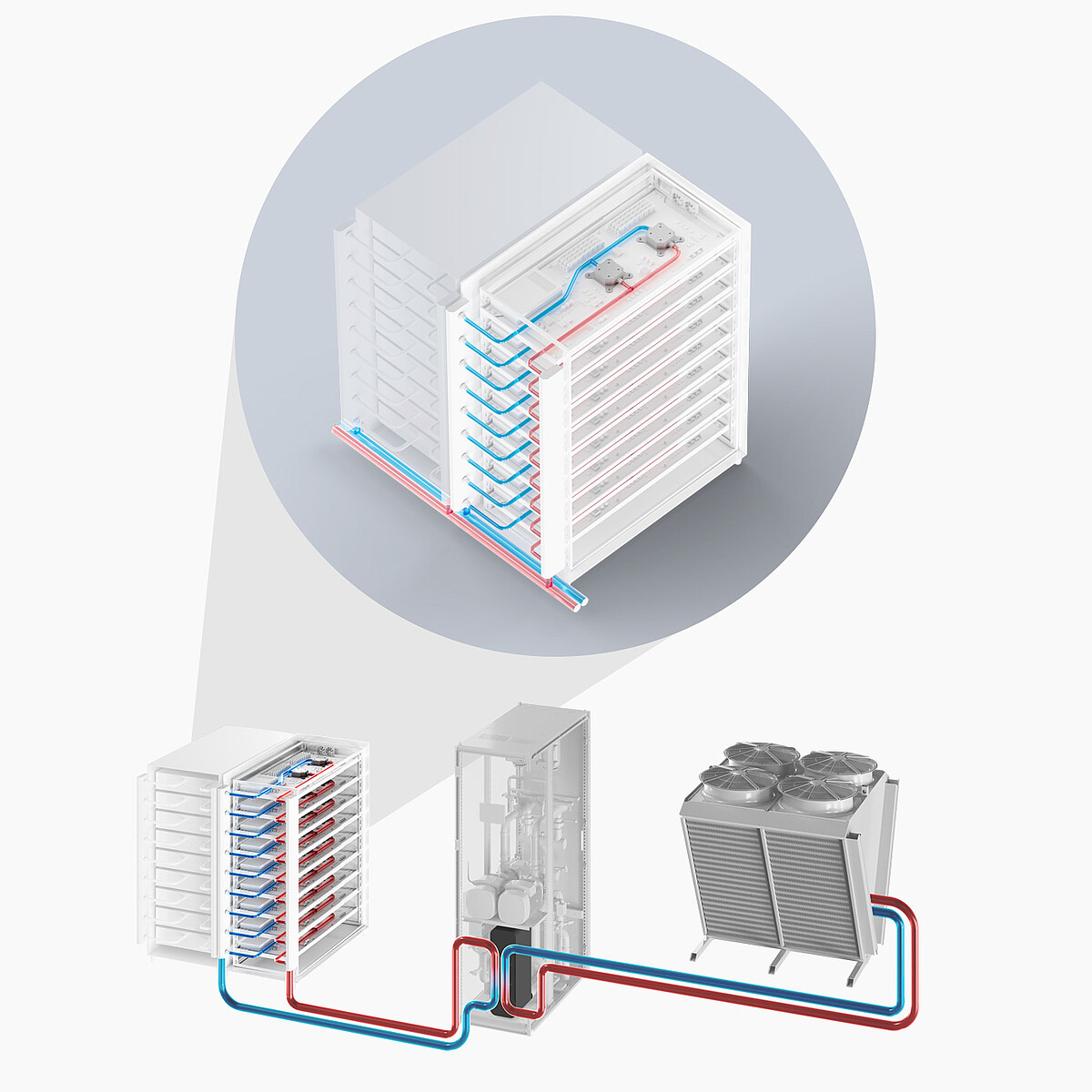

Direct-to-Chip Cooling

แนวทางยอดนิยมในปัจจุบัน ใช้แผ่น Cold Plate ที่ทำจากวัสดุนำความร้อนดี เช่น ทองแดงหรืออะลูมิเนียม ประกบเข้ากับตัวสร้างความร้อนหลักอย่าง CPU, GPU หรือชิปประมวลผลเฉพาะทาง จากนั้นให้ของเหลวหล่อเย็นไหลผ่านช่องภายใน Cold Plate เพื่อดึงความร้อนออกโดยตรงระบบนี้เหมาะมากกับ High Density Rack ที่ต้องการการควบคุมอุณหภูมิแบบเป๊ะๆ และไม่ยอมให้เครื่องร้อนเกินกรอบแม้แต่นิดเดียว

Immersion Cooling

อีกขั้นของเทคโนโลยี ที่ยกทั้งเซิร์ฟเวอร์หรือทั้ง Rack ไป จุ่มลงในของเหลวชนิดพิเศษ ที่เรียกว่า Dielectric Fluid ซึ่งไม่เป็นสื่อนำไฟฟ้า ปลอดภัย และระบายความร้อนได้ดีของเหลวจะสัมผัสทุกชิ้นส่วนของเซิร์ฟเวอร์โดยตรง ทำให้การถ่ายเทความร้อนเกิดขึ้นครบทุกมุมอย่างทั่วถึง รองรับ Rack ที่มีความหนาแน่นโหดมากๆ ได้สบาย แถมยังช่วยลดเสียงพัดลมและลดการใช้พัดลมภายในอุปกรณ์ได้อย่างชัดเจน

ข้อดีของ Liquid Cooling ที่ Air Cooling เทียบไม่ติด

การเปลี่ยนมาใช้ Liquid Cooling ใน Data Center ไม่ใช่เทรนด์เล่นๆ แต่เต็มไปด้วยข้อดีที่จับต้องได้

รองรับ High Density Rack อย่างแท้จริง

ด้วยความสามารถในการระบายความร้อนที่เหนือกว่าอากาศหลายเท่า Liquid Cooling สามารถจัดการ Rack ที่ใช้พลังงาน 30–100 kW ได้อย่างมีประสิทธิภาพ ซึ่งเป็นระดับที่ระบบปรับอากาศทั่วไปทำไม่ไหว ส่งผลให้ Data Center สามารถอัดพลังประมวลผลต่อพื้นที่ได้สูงขึ้นมากประหยัดพลังงาน (Energy Efficiency)

เมื่อพึ่งพาระบบปรับอากาศขนาดใหญ่และพัดลมจำนวนน้อยลง ค่าไฟก็ลดลงตามไปด้วยอย่างมีนัยสำคัญ ตัวเลขอย่าง PUE (Power Usage Effectiveness) สามารถลดลงได้ชัดเจน โดยมีตัวอย่าง Data Center ที่ใช้ Immersion Cooling แล้วดึงค่า PUE ลงมาเหลือต่ำกว่า 1.1 ได้เลย ซึ่งถือว่าโหดมากในแง่ประสิทธิภาพพลังงานความเสถียรสูง (High Reliability)

เมื่ออุณหภูมิของอุปกรณ์ถูกควบคุมให้คงที่อยู่ในช่วงเหมาะสม ความเสี่ยงจากการ Overheat หรืออุณหภูมิแกว่งแรงๆ ก็ลดลง ซึ่งเป็นสาเหตุหลักของ Hardware Failure หลายกรณี ส่งผลให้ระบบทำงานนิ่งขึ้น และยืดอายุการใช้งานของอุปกรณ์ไปในตัว

ทิศทางอนาคต: Liquid Cooling กำลังจะกลายเป็นมาตรฐาน

เมื่อ AI และ HPC (High Performance Computing) ต้องการพลังประมวลผลระดับมหาศาล แนวโน้มก็ชัดเจนว่า ความหนาแน่นของอุปกรณ์ใน Rack จะยิ่งสูงขึ้น และความร้อนก็จะทวีความโหดขึ้นตาม

ในช่วง 5–10 ปีข้างหน้า มีการคาดการณ์ว่า Data Center ขนาดใหญ่ โดยเฉพาะระดับ Hyperscale จะหันมาใช้ Liquid Cooling เป็นโครงหลักของระบบระบายความร้อน เพื่อรองรับ Workload ที่ทั้งแน่นและซับซ้อน

อย่างไรก็ตาม Liquid Cooling ไม่ใช่ของที่ยกมาติดตั้งเพิ่มง่ายๆ ในทุกอาคาร จำเป็นต้อง

ออกแบบตั้งแต่ระดับอาคารและโครงสร้างพื้นฐาน

เลือกประเภท Liquid Cooling ให้เหมาะกับอุปกรณ์และงาน

วางแผนร่วมกับทีมวิศวกรรมตั้งแต่ต้น

ดังนั้น การคุยกับวิศวกรและผู้เชี่ยวชาญด้านระบบระบายความร้อนตั้งแต่เฟสออกแบบ จึงสำคัญมาก เพื่อให้ได้ระบบที่ทั้งเหมาะสม คุ้ม และมีประสิทธิภาพสูงสุดในระยะยาว

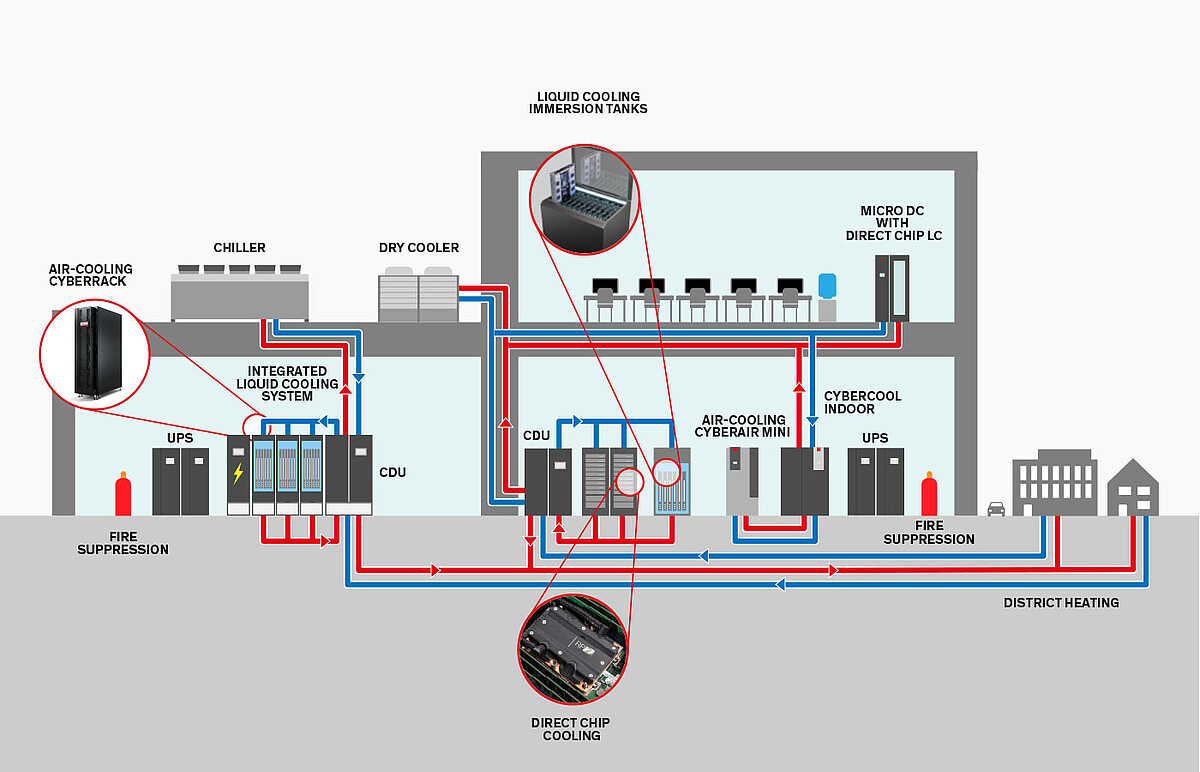

STULZ Liquid Cooling: ทำไมวิศวกรถึงไว้ใจทั่วโลก

ในโลกของ Data Center ที่ทุกวินาทีมีข้อมูลถูกประมวลผลอย่างหนาแน่น โดยเฉพาะงานด้าน AI และ HPC การเลือกระบบระบายความร้อนผิดชีวิตเปลี่ยนได้เลย

แบรนด์อย่าง STULZ ซึ่งมีประสบการณ์ด้าน Mission-Critical Cooling มากว่า 50 ปี จึงกลายเป็นหนึ่งในชื่อที่ถูกพูดถึงบ่อยในวงการ Liquid Cooling เพราะไม่ได้มาแค่ขายฮาร์ดแวร์ แต่เสนอเป็นโซลูชันครบวงจรที่ได้รับการยอมรับในระดับอุตสาหกรรม

1. ประสิทธิภาพการระบายความร้อนที่ออกแบบมาเพื่อ High Density จริงๆ

ระบบ Liquid Cooling ของ STULZ ถูกออกแบบมาเพื่อจัดการความร้อนจาก High Density Rack โดยเฉพาะ รองรับตู้แร็คที่กินไฟระดับ 100 kW หรือมากกว่า ซึ่งถือว่าเกินขอบเขตของ Air Cooling ไปไกลแล้ว

ด้วยเทคโนโลยี Direct-to-Chip Cooling ที่ใช้ Cold Plate ติดตั้งกับชิปที่ร้อนที่สุดอย่าง CPU และ GPU แล้วให้น้ำหล่อเย็นไหลผ่านเพื่อลากความร้อนออกไป ทำให้สามารถควบคุมอุณหภูมิได้แม่นยำ เซิร์ฟเวอร์ทำงานเต็มประสิทธิภาพ ลดโอกาส Overheat ได้อย่างชัดเจน

2. ยืดหยุ่น ออกแบบและขยายระบบได้ง่าย (Scalability & Customization)

STULZ เข้าใจดีว่า Data Center แต่ละแห่งไม่มีใครหน้าไหนเหมือนกัน จึงออกแบบโซลูชันให้ยืดหยุ่นสูง ทั้งในแง่สถาปัตยกรรมและการขยายในอนาคต

ตัวอย่างเช่น

ใช้ Coolant Distribution Unit (CDU) ทำงานร่วมกับระบบ Chilled Water เดิมของอาคารได้อย่างลื่นไหล

มีตัวเลือกโซลูชันแบบ All-in-one ที่ประกอบและทดสอบจากโรงงานมาเรียบร้อย ติดตั้งแล้วใช้งานได้แทบจะทันที

ไม่ว่าจะเพิ่มจำนวนตู้แร็ค หรือเพิ่มความหนาแน่นของอุปกรณ์ในอนาคต ก็สามารถขยายระบบได้ง่าย ไม่ต้องรื้อทั้ง Data Center ทิ้ง

3. ประหยัดพลังงาน และตอบโจทย์ Sustainability

หนึ่งในจุดเด่นของ STULZ Liquid Cooling คือช่วยลดค่าไฟได้แบบจริงจัง ระบบสามารถทำงานที่อุณหภูมิน้ำหล่อเย็นที่สูงขึ้น หรือที่เรียกว่า Warm Water Cooling เปิดโอกาสให้ใช้ Free Cooling ได้แทบทั้งปี แม้ในประเทศที่อากาศค่อนข้างอบอุ่น

เมื่อพึ่งพาระบบทำความเย็นเชิงกล (Mechanical Cooling) และพัดลมขนาดใหญ่ลดลง ค่า PUE ก็ลดตามอย่างมีนัยสำคัญ ผลลัพธ์คือ

ค่าไฟลด

การปล่อยคาร์บอนไดออกไซด์ลดลง

ช่วยองค์กรขยับเข้าใกล้เป้าหมายด้านความยั่งยืน (Sustainability) ได้ไวขึ้น

4. ความน่าเชื่อถือ และความปลอดภัยระดับ Mission-Critical

หนึ่งในความกังวลใหญ่ของคนที่มอง Liquid Cooling คือเรื่อง น้ำรั่ว แต่ STULZ ก็ออกแบบระบบมาเพื่อลดความเสี่ยงจุดนี้โดยเฉพาะ

แยกวงจรน้ำของฝั่ง IT (Technology Cooling System: TCS) ออกจากน้ำฝั่งอาคาร (Facility Water System: FWS) อย่างชัดเจน เพื่อลดโอกาสปนเปื้อน

เสริมระบบ Leak Detection สำหรับตรวจจับการรั่วไหล

วางดีไซน์ให้ ซ่อมบำรุงง่าย ลด Downtime ให้เหลือน้อยที่สุด

ทั้งหมดนี้ทำให้ระบบพร้อมทำงาน 24/7 ซึ่งเป็นเงื่อนไขสำคัญที่สุดของ Data Center ที่ไม่อนุญาตให้ล่ม

5. ได้มากกว่าฮาร์ดแวร์ เพราะได้ทีมผู้เชี่ยวชาญทั้งระบบ

STULZ ไม่ได้จบแค่การขายอุปกรณ์ แต่ทำตัวเป็น พาร์ทเนอร์ด้านเทคนิค ตั้งแต่ขั้นตอนออกแบบ ติดตั้ง ไปจนถึงการดูแลรักษาระยะยาว

ด้วยทีมวิศวกรที่มีความเชี่ยวชาญและเครือข่ายบริการทั่วโลก ลูกค้าจึงได้รับทั้งคำปรึกษา แนวทางออกแบบ และการสนับสนุนที่ทำให้ระบบ Liquid Cooling ทำงานได้เต็มศักยภาพ และตอบโจทย์เป้าหมายทางธุรกิจในระยะยาวอย่างแท้จริง

สรุป: ใครคิดจะเล่นใหญ่ด้าน AI และ HPC ต้องคิดถึง Liquid Cooling ตั้งแต่วันออกแบบ

เมื่อพลังประมวลผลกลายเป็นสนามแข่งขันหลักของยุค AI การวางระบบระบายความร้อนให้รองรับ High Density Rack ตั้งแต่แรกไม่ใช่ทางเลือก แต่เป็น เงื่อนไขบังคับ

Liquid Cooling จึงไม่ใช่แค่เทคโนโลยีล้ำๆ แต่คือโครงสร้างพื้นฐานที่ทำให้ Data Center สามารถขับเคลื่อนงาน AI, Cloud และ HPC ได้แบบไม่ติดเพดานความร้อน ใครวางแผนดีกว่า ก็วิ่งได้ไกลกว่าในเกมนี้อย่างหลีกเลี่ยงไม่ได้